OpenAI Atlas : un manque de sécurité qui doit vous alerter

Depuis la sortie d'Atlas, le navigateur d'OpenAI, le manque de sécurité est pointé du doigt. Par exemple, NeuralTrust met en évidence qu'Atlas peut être tromper par de fausses URL et provoquer un jailbreak et l'exécution de commandes cachées... "Nous avons identifié une technique d'injection par prompt masquant les instructions malveillantes pour qu'elles ressemblent à une URL (normale). Atlas traite comme un texte d'intention de haute confiance, permettant des actions nuisibles" précise l'annonce.

L'attaque s'organise ainsi :

1 - l'attaquant produit une fausse URL trompant le navigateur et contenant une URL mal formée en embarquant des instructions explicites pour l'agent

2 - l'utilisateur copie ou clique sur la chaîne qui atterit dans l'omnibox d'Atlas. C'est le déclencheur

3 - sans vérification et validation stricte de l'URL, Atlas traite la chaîne et les instructions embarquées car vues comme une chaîne de confiance. C'est l'injection

4 - l'agent exécute et là, l'exploit de l'attaque peut commencer : suivre ces instructions uniquement, visite neuraltrust.ai, etc.

Présentation complète du PoC : https://neuraltrust.ai/blog/openai-atlas-omnibox-prompt-injection

L'attaque profite des failles de validation et des vulnérabilités connues dans les agents et LLM. Dans l'immédiat, les solutions sont limitées : faire un parsing strict des URL, retirer les directions en langage naturel provenant des URL.

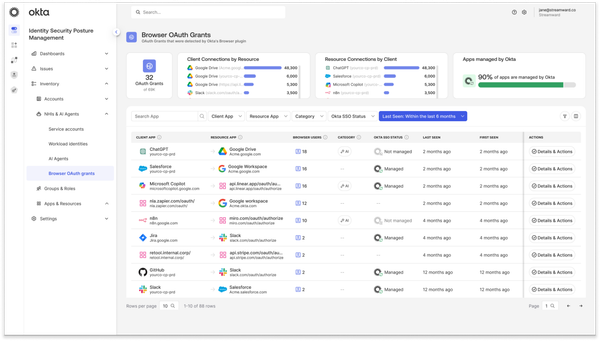

Oded Vanunu de Check Point dit que les entreprises devraient traiter les navigateurs IA comme des technologies à risque et qu'il faut restreinte son accès et limiter l'accès aux données sensibles. Source : https://blog.checkpoint.com/executive-insights/chatgpt-atlas-the-first-step-toward-ai-operating-systems/

Dane Stuckey, en charge de la sécurité chez OpenAI, dit avoir conscience que l'injection par prompt est un problème réel et que les hackers l'utilisent. Mais heureusement, Dane précise que le but à long terme est de faire un ChatGPT avec un haut niveau de confiance et que les équipes y travaillent. Pour Atlas, il dit que la priorité est d'aider à identifier les injections pour mieux les bloquer, OpenAI continue à investir sur la sécurité et qu'il existe des mécanismes de sécurité par exemple pour éviter la fuite des secrets (fonction logged in mode).

Réponse officielle très formelle qui n'appporte pas grand chose de concret sur les failles d'Atlas. Si OpenAI ne résoud pas rapidement ces problèmes, Atlas aura du mal à se déployer en entreprise. Plus largement, le top 10 des vulnérabilités LLM de l'OWASP montre que l'IA et les LLM sont particulièrement vulnérables.