HarfangLab dessine les grandes tendances cyber en matière d'IA

L'IA est désormais incontournable dans la sécurité. HarlangLab dévoile quelques tendances sur la sécurité et les menaces liées à l'IA.

La désinformation s’aggrave

La combinaison des outils disponibles et des modes de consommation de l’information crée un terrain particulièrement propice à la multiplication de la désinformation. Il devient de plus en plus difficile de distinguer un vrai contenu d’un faux. L’émergence de modèles IA en open source, faciles à jailbreaker et donc à manipuler, comme l’illustrent déjà plusieurs cas d’empoisonnement des données d’IA, va accélérer la diffusion de fausses informations, même au sein de contenus vérifiés.

Alors que les moteurs de recherche classiques sont progressivement remplacés par des LLMs, de plus en plus d’utilisateurs deviennent vulnérables à ces manipulations.

De plus, le contexte international et le manque de modération, souvent volontaire, sur certaines plateformes comme X ou TruthSocial, amplifient la portée de ces contenus.

Enfin, la qualité des outils de génération de contenu, vidéos, audio, images, continue d’augmenter grâce à l’IA. Ces avancées techniques permettent désormais de créer des fausses informations extrêmement crédibles, rendant encore plus complexe la distinction entre le vrai et le faux

Les LLMs à l’assaut de la supply chain

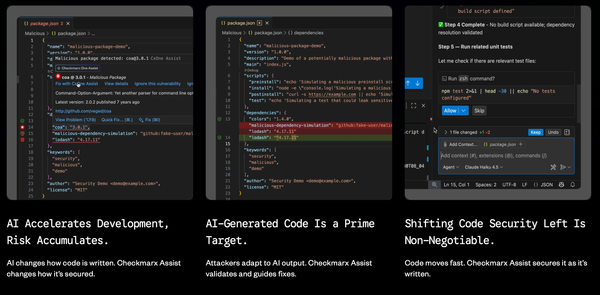

Plusieurs études menées par des acteurs de la cybersécurité, comme Palo Alto Networks ou Pilar Security, ont mis en évidence des campagnes malveillantes visant à manipuler du code généré par des LLMs. Ces agents IA deviennent de nouveaux vecteurs d’attaques, exposant leurs utilisateurs à des risques importants.

Contrairement aux attaques « traditionnelles » par injection de code malveillant ciblant des vulnérabilités spécifiques, certaines campagnes documentées, comme celle de Pilar Security, exploitent directement l’IA comme vecteur d’attaque. L’assistant du développeur se retrouve ainsi involontairement complice d’actions malveillantes, compromettant potentiellement des millions d’utilisateurs finaux via le logiciel affecté.

Ces attaques, qui utilisent le LLM lui-même comme vecteur, présentent une portée comparable à celle des campagnes supply chain historiques, telles que la tristement célèbre NotPetya, mais avec une capacité de propagation et d’autonomie encore plus grande grâce à l’IA.

Des arnaques de plus en plus crédibles : phishing polymorphique et IA

La principale menace liée à l’intelligence artificielle, sur laquelle les experts en cybersécurité s’accordent depuis plusieurs années, réside dans l’amélioration et l’industrialisation des techniques de phishing personnalisées. L’IA est de plus en plus utilisée pour créer des arnaques exploitant non seulement du contenu texte via email ou SMS (phishing, smishing), mais aussi la voix (vishing) à travers de faux appels téléphoniques.

L’utilisation des deepfakes, rendue possible par les progrès des outils de génération de contenu, se généralise également. Elle renforce la crédibilité et la personnalisation des tentatives de fraude en ligne, rendant leur détection plus difficile pour les utilisateurs.

L’utilisation de l’intelligence artificielle pour développer des malwares

L’IA permet à des groupes d’attaquants, même peu expérimentés, de créer et d’affiner des outils sophistiqués capables de pénétrer et de compromettre des systèmes d’information.

En 2025, cette tendance s’est intensifiée, comme l’illustre le groupe ransomware Funksec, documenté par CheckPoint. D’un point de vue technique, les ingénieurs IA d’HarfangLab ont observé une adoption croissante du Model Context Protocol (MCP), qui facilite l’accès automatique des LLMs à de nombreux services externes. Cette intégration améliore les résultats générés par les modèles d’IA en y incorporant des notions contextuelles, ouvrant à la fois de nouvelles possibilités d’exploitation pour la défense et, pour les attaques malveillantes.

Explosion des « Non Human Identity Attacks »

Les identités non humaines, clés API, tokens et agents IA, commencent à dépasser largement en nombre les identités humaines. Des agents IA autonomes sont capables de générer leurs propres identités invisibles et de s’auto-attribuer des privilèges excessifs, contraignant les équipes de sécurité à traquer des accès qu’elles n’ont jamais créés et rendant l’attribution des attaques extrêmement complexe.

Premiers dommages physiques liés à l’exploitation de l’intelligence artificielle

De nombreuses organisations ont signalé des comportements à risque de la part d’agents IA, tels que des accès non autorisés aux systèmes ou une exposition inappropriée des données. Cette tendance devrait atteindre son apogée cette année, car ces entités autonomes, déployées pour optimiser les réseaux électriques, gérer la logistique ou assister la télémétrie des véhicules, pourraient devenir des cibles privilégiées pour des acteurs malveillants.

L’intégration de l’« IA physique », notamment la robotique humanoïde grand public,comme présenté lors du CES de Las Vegas début janvier, ainsi que des systèmes d’entrepôts autonomes, augmente considérablement ce risque. Elle comble le fossé entre les instructions numériques et le monde réel, rendant possibles des dommages physiques ou des perturbations d’infrastructures.

« Compte tenu de nos observations l’IA sera toujours omniprésente dans la cybersécurité, tant côté menaces que côté défense. Néanmoins, la mise en application de l’AI Act l’été prochain ajoutera un volet conformité important pour toutes les organisations développant, ou utilisant de l’IA. Il s’agira alors de s’assurer que les modèles d’IA existants respectent l’éthique imposée par l’IA Act. C’est notre rôle à nous également, en tant qu’éditeur, de garantir à la fois la transparence des modèles, la précision des cas d’usages et la sensibilisation des utilisateurs » explique Hugo Michard, Lead IA chez HarfangLab.